El generador de imágenes de OpenAI es eficiente, versátil y poderoso. Un ingenio que parece salido de la ciencia ficción y que está abierto al público, incluso para los que no son expertos en prompts. Sin embargo, no todo es color de rosas en ese sistema ahora integrado en forma nativa en ChatGPT. Una serie de fallas de DALL-E quedan al descubierto cuando le pedimos que incluya texto en las fotos o dibujos.

¿Por qué decimos que parece de ciencia ficción? Eso hubiésemos creído cualquiera de nosotros pocos años atrás. Por entonces, para generar una imagen como las que entrega DALL-E se necesitaba acceso a programas especializados, conocimientos extensos y una buena cantidad de tiempo. Ahora, alcanza con un prompt, que en la jerga de la inteligencia artificial es la instrucción que el usuario le dicta al modelo. Por ejemplo, si se escribe “crea una imagen en la que un perro saca su lengua mientras pedalea en un monociclo”, estos generadores —DALL-E no es el único— entregan sus resultados en segundos.

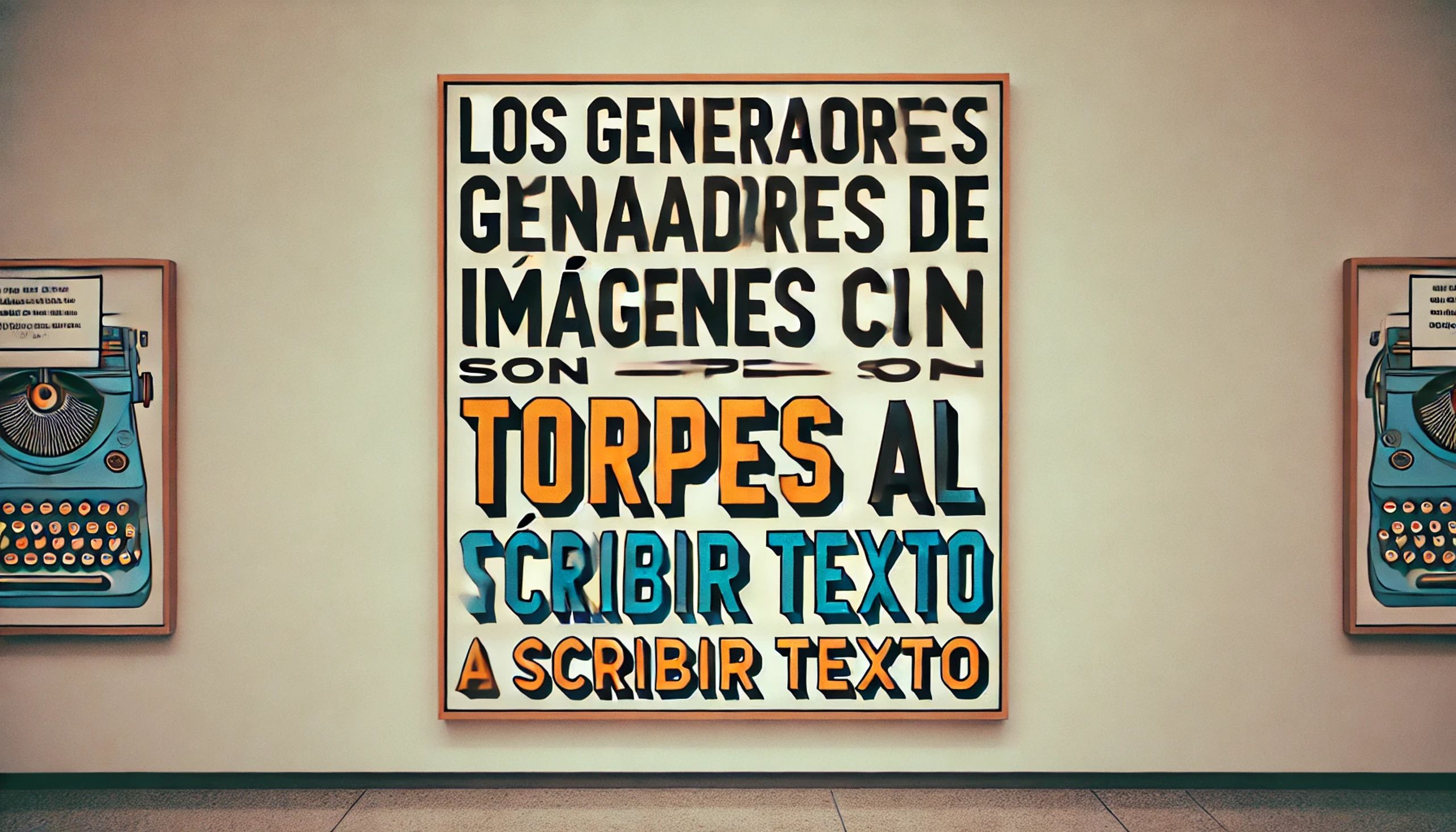

Como decíamos, las fallas de DALL-E surgen al incluir solicitudes como “muestra un cartel en el que se lea la siguiente frase”. Por alguna razón, en la que ahondaremos en este repaso de Hipertextual, la poderosa tecnología de OpenAI tropieza. Los textos son extrañísimos, con errores de tipeo e incluso signos entremezclados que no existen en ningún alfabeto. Para desentrañar el misterio hablamos con una especialista en inteligencia artificial y “entrevistamos” al mismísimo ChatGPT.

Fallas de DALL-E: el generador más avanzado tropieza con los textos en las imágenes

La imagen sobre este párrafo fue generada como el prompt mencionado más arriba. La tecnología de la organización estadounidense demoró apenas segundos en crearla. Sin lugar a dudas, cumple que lo que se le pide. Es un perro, muestra la lengua, hace equilibrio en un monociclo. Si quisiéramos alternativas será suficiente pedirlas con una nueva instrucción.

Las fallas de DALL-E brotan apenas pedimos que trabaje con palabras. La ilustración que abre este repaso es uno entre los tantos ejemplos. Repite la palabra “generadores”, por cierto, con errores. En lugar de “con” aparece un extraño “cin”. Acertó felizmente al escribir “torpes”, pero sobre el final profundiza su ineficiencia al intentar, sin suerte, trazar la palabra “escribir”. También aquí son válidas las segundas oportunidades. Aunque, como vemos a continuación, la máquina tropieza con la misma piedra.

Un detalle crucial antes de avanzar en este examen. En nuestras pruebas, hemos detectado las falencias mencionadas tanto en la versión gratuita de DALL-E, a través de ChatGPT, como en la variante con suscripción, ChatGPT Plus, en este caso con GPT-4o. En otras palabras, pagar no os salvará de esta falla. Al menos por ahora.

“Estas fallas de DALL-E son lógicas”, dice una experta en IA

Según Marcela Riccillo, doctora en Ciencias de la Computación y especialista en inteligencia artificial, “es lógico que DALL-E falle al incorporar texto a una imagen”.

¿Por qué ocurren estas fallas en DALL-E? ¿Tan complejos son los textos en un entorno visual?

Supongamos que alguien le pide a una persona que agregue su nombre a una imagen, por caso de un paisaje. Si lo hace con un editor simple, sería un rectángulo blanco con el nombre en alguna parte de la imagen. Tal vez en medio de la montaña o el cielo. Pero el resultado no es lo que la persona imaginaba, sino que el nombre estuviera incluido en la imagen. Por ejemplo, un pequeño cartel que parezca real junto al río. Eso implicaría que el cartel debería ser de un tamaño acorde al espacio entre el río y la montaña, respetando las sombras y que no fuera un rectángulo, sino una forma que siguiera la dirección del río.

Teniendo en cuenta ese ejemplo, es importante entonces que la persona le indique a la máquina con detalle la forma y lugar del texto. “Incluir un cartel» o «incluir tal palabra» sin detalle, a priori podría generar frustración entre la expectativa y el resultado. También podría haber diferencias entre lo que la persona imagina, y el tamaño y tipo de letra del texto resultante.

Suponemos, además, que incrustar palabras en escenarios variables conduce a las fallas de DALL-E que estamos mencionando…

Claro. Si se tiene una imagen creada con personas y se le dice a la máquina que incluya determinado texto «en un brazalete» o «en una sudadera», por ejemplo, el sistema debe tener en cuenta texturas, luces y sombras de la imagen para que el texto sea acorde a la misma.

Las aplicaciones como DALL-E fueron entrenadas con imágenes y de ellas «deducen» cómo adaptar el texto en su ubicación. Los textos en la calle, los carteles, los nombres de empresas, los escritos en camiones, etcétera, generalmente no están completos. Algunas partes, algunas letras, están tapadas por ramas, reflejos del sol, personas que están caminando. Por ejemplo, en el caso del brazalete, si el brazo está apoyado en una mesa, se vería solamente el principio del texto, y el resto estaría bajo la parte del brazo sobre la mesa. Y la sudadera, tendría pliegues que taparían algunas letras.

¿Estas fallas de DALL-E se explican, entonces, por cómo se replican los textos en el mundo real, a diferencia de lo que ocurre, por caso, en un cartel o un libro?

La máquina trata de imitar el efecto que se ve en la realidad y oculta parte del texto, lo escribe incompleto porque así fue entrenado. Además, varios sistemas de IA generativa incluyen detalles en la parte de la imagen que está en primer plano, pero el fondo al desdibujarlo, queda a veces incongruente. Por ejemplo, plantas donde no se esperan. También cuadrados o formas en el fondo que no se puede interpretar qué serían en la vida real). Con textos en segundo plano pasa algo similar y podrían quedar ilegibles.

“Entrevistamos” a ChatGPT para comprender por qué falla al trabajar con textos en las imágenes

En sintonía con las explicaciones de Riccillo, desde OpenAI indican que “los errores que ocurren al generar texto en las imágenes se deben a varias razones, relacionadas con la naturaleza del modelo de inteligencia artificial y su entrenamiento”. Siendo que el chatbot de esa organización es un buen conversador, le trasladamos nuestras preguntas como si se tratase de una entrevista con la fuente directa.

Dime, ChatGPT, ¿por qué encontramos las fallas de DALL-E cuando le pedimos que incluya texto en las imágenes que genera?

DALL-E se entrena en un conjunto de datos que contiene tanto imágenes como descripciones textuales. Sin embargo, no está específicamente optimizado para generar texto con precisión tipográfica o gramatical. Su principal objetivo es generar imágenes que coincidan con la descripción general, no necesariamente para escribir texto perfecto. En ese sentido, aunque puede entender y generar descripciones visuales complejas, su capacidad para reproducir texto exacto es limitada. Generar imágenes con texto preciso implica un nivel de control y detalle que puede no estar dentro de las capacidades del modelo, especialmente cuando se trata de tipografía y alineación exacta.

Respecto a estas fallas en DALL-E que reconoces, ¿qué tan complejo sería incorporar una solución?

Crear texto legible en una imagen requiere un alto nivel de detalle y precisión en los píxeles. DALL-E, como generador de imágenes basado en IA, puede tener dificultades para representar texto con la claridad y precisión necesarias, especialmente en tamaños pequeños o en fuentes complejas. El modelo no está específicamente entrenado para tareas de diseño gráfico o creación de carteles con texto exacto. Sus capacidades están más orientadas a la generación de conceptos visuales basados en descripciones textuales. Es importante mencionar que cuando se genera una imagen, el modelo hace compromisos entre varios elementos visuales. Al intentar incluir texto, puede priorizar la coherencia visual general sobre la precisión del texto específico.

¿Qué propones a los usuarios que desean incluir texto en sus imágenes, para superar estas fallas de DALL-E?

Para superar estas limitaciones, una opción es generar la imagen sin texto y luego añadir el texto mediante herramientas de edición de imágenes, como Photoshop o GIMP, que están diseñadas específicamente para manejar texto con precisión. Esto combina las fortalezas de DALL-E en la generación de imágenes con las capacidades precisas de las herramientas de edición gráfica para la manipulación de texto.

Sigo sin entender lo siguiente. ¿Por qué vuestro generador es tan eficiente al crear escenas realmente complejas, pero no trabaja bien con el texto? ¿Acaso las letras no son, a fin de cuentas, un tipo de gráfico?

Ten en cuenta que los objetos en las imágenes (como un coche, un árbol o una persona) tienen formas y estructuras que DALL-E ha aprendido a reconocer y replicar a partir de un gran volumen de datos de entrenamiento. Estas formas suelen ser complejas y variadas, lo que permite al modelo generalizar bien y crear representaciones visuales precisas. En cambio, ¿qué ocurre con el texto? Aunque las letras son gráficamente simples, requieren una alineación precisa y un orden específico para formar palabras y frases legibles. Esta precisión es difícil de lograr porque DALL-E no está específicamente optimizado para comprender y reproducir la tipografía de manera exacta.

Finalmente, estas fallas en DALL-E se explican por el modo en que es adiestrado. En los datos de entrenamiento, las imágenes con texto (como carteles, anuncios, etcétera) son menos comunes en comparación con las imágenes de objetos y escenas. Esto significa que el modelo tiene menos ejemplos de texto para aprender y reproducir con precisión.

Cuando DALL-E intenta generar texto, pequeños errores en la colocación o el tamaño de las letras pueden hacer que el texto sea ilegible. Estos errores no afectan tanto a la generación de objetos porque los humanos pueden reconocer y corregir visualmente formas que no sean perfectas, pero el texto requiere exactitud. Además, el texto, especialmente en tamaños pequeños, puede requerir más detalles de los que el modelo puede manejar con precisión en una resolución limitada.

Fallas de DALL-E al trabajar con texto: promesa de mejoras y perspectivas en el generador de videos Sora

Cuando le consultamos a ChatGPT si en el futuro cabe la posibilidad de que estas fallas de DALL-E sean solucionadas, el chatbot mostró optimismo. Por un lado, señaló que es probable que tanto OpenAI como otros desarrolladores de IA trabajen para mejorar esta capacidad, ahora trunca. “La habilidad de generar texto preciso en imágenes es una característica muy solicitada, especialmente para aplicaciones en diseño gráfico, publicidad y creación de contenido. Por eso, la demanda de los usuarios puede impulsar a OpenAI a enfocar recursos en mejorar esta capacidad”, respondió la máquina.

Por lo demás, en función del avance vertiginoso en el área, no resulta descabellado que las próximas tecnologías permitan a DALL-E y otros de su especie superar los inconvenientes al trabajar con texto. En ese camino, subrayan desde OpenAI, una de las claves será el entrenamiento más específico. Es decir, el uso de conjuntos de datos que incluyan más ejemplos de texto en contextos visuales variados. Además, un paso evolutivo será la integración de OCR —tecnologías de reconocimiento óptico de caracteres— para validar y corregir los textos y<generados.

Además de las fallas de DALL-E, ChatGPT —incluso en su versión de pago— también presenta algunas limitaciones. Cuando le preguntamos si ocurrirá lo mismo en Sora, el generador de videos que ya anunció OpenAI y que aún no se lanzó, el chatbot reconoció que no sabe de qué se trata ese modelo. “No tengo información específica, porque mi última actualización se realizó en diciembre de 2023”, respondió. Mientras tanto, podemos suponer que Sora tendrá esa misma falencia al trabajar con textos, por las mismas razones esgrimidas para DALL-E.

Gemini tiene el mismo problema

A modo de cierre, cabe remarcar que la repasada falla de DALL-E no es exclusiva de este generador. El modelo de Gemini que crea imágenes también presenta la misma dificultad, tal como vemos sobre este párrafo. Por lo demás, aquel sistema de Google aún no realiza este trabajo en idioma español, según comprobamos al probar con la versión de acceso gratuito.